根据最新资料显示,目前我国数据中心的数量已超过1844个,机架总体规模已超过166万架。但由于传统供电架构等原因,能耗效率与国际先进水平有较大差距,且在二氧化碳、污水处理等绿色智能数据中心的重点指标上依然有巨大提升空间。

目前,我国政府已经提出了《国家绿色数据中心的试点方案》,大力提倡数据中心要“节能减排”,走绿色智能的发展道路。众所周知,能效参照水平pue值越低,代表能耗利用率越高,从pue指数来看,百度的数据中心单模组早在2017年就达到了1.10。那么百度云计算(阳泉)中心是如何做到pue1.10,又能否复制再推广这种模式呢?

“一方面是电气架构的不断升级、空调末端改造等设备优化,另一方面,从服务器、免费冷却、智能管理等所有与idc能效相关的技术都是处于不断快速迭代升级的状态,这才是我们pue达到如此高水平的关键。”百度云计算(阳泉)中心负责人顾鹏如是说。

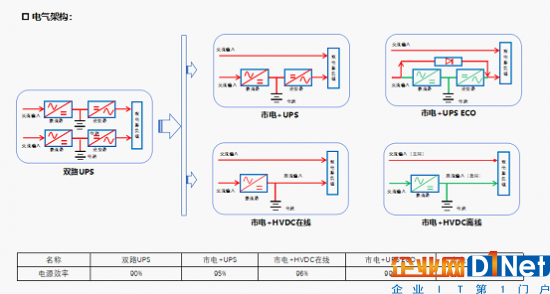

供电架构优化升级提高利用效率

首先从供电架构上,百度云计算(阳泉)中心采用市电 ups、市电 ups(eco)模式、市电 高压直流在线、市电 高压直流离线四种架构。其中市电 高压直流 离线的供电架构是世界首例,结合国内首批内置式锂电池机柜的部署,使供电效率从传统2n冗余ups双路供电的90%大幅度提高到了99.5%,最大限度地利用了资源。

目前,百度云计算(阳泉)中心通过对电气架构进行的不间断优化升级,每年能为数据中心节约用电量高达2.5亿度,大约相当于13万个家庭全年用电量的总和。

图示为百度云计算(阳泉)数据中心供电架构示意图

免费冷却技术不断迭代能耗持续降低

百度云计算(阳泉)中心的另一个节能方式在于暖通架构。百度云计算(阳泉)中心同时采用了crah(冷冻水槽精密空调)、ahu(组合式空调箱)、idec(间接风测)和ocu这四种新型的空调末端形式。百度自研置顶冷却单元ocu(overhead cooling unit)新型空调末端,与预制模块技术结合,冷却模块垂直安装在机架上方,空调末端无风扇、零功耗,利用空气对流原理,可以抽走“热通道”的热空气的同时,还可以送出冷空气给“冷通道”。此外,传统服务器要求环境温度为5~35℃,服务器一般运行在25℃左右,百度特别研究的高温服务器,其耐温设计高达45℃,更少的冷源需求也大幅降低了数据中心能源消耗。

目前,百度云计算(阳泉)中心全年免费冷却已经达到96%,相当于每年用冷机的时间只有两周时间,剩下的大部分时间都是使用自然冷源状态。此外,冷却过程中产生的污水,百度云计算(阳泉)中心还会将其进行回收再利用,每年回收量高达48万吨,相当于四千户家庭一年的用水量。

图示为百度云计算(阳泉)数据中心暖通架构示意图

除此之外,百度云计算(阳泉)中心大量使用清洁能源,将节能做到极致。2017年百度阳泉数据中心签约风能和太阳能共2600万度,占比整个用电量的16%,2018年使用风能和太阳能可以达到五千五百万5500万度,预计占比可能达到23%左右以上。

ai深度应用智能不断升级

在高度智能化的百度云计算(阳泉)中心,目前已全面实现无纸化操作,通过pad 、电脑进行巡检。并提前将数据上传到电脑,巡检人员只需对照相应数据,即可判断运行状态是否良好。

此外,百度云计算(阳泉)中心还建立了数据中心深度学习模型,比如冷水机组三种模式的运行就通过ai自动运营判断,根据室外天气湿度、温度和负荷,切换制冷模式、预冷模式和节约模式,此外ai还能实现智能预警,通过负载情况,预判it设备磨损运行情况,给出维护策略。

ai另一个大显身手之处是做到了智能调度,百度云计算(阳泉)中心将每一台设备的运算模型都放在一套逻辑里,ai会根据逻辑自主判定出运行中的设备负荷量是否达到要求。例如以前运营几台设备比较节能,只能靠人的经验判断,而现在ai会根据运行情况进行判断,靠数据精准调控。

供电效率的提高、能源消耗的降低、绿色能源的替代、智能管理……,可以说,想要再造一个像百度云计算(阳泉)中心这样的绿色数据中心,绝非易事,无论是先进的架构和技术,还是借助ai的基础,都不是一朝一夕可以达到的事情。但是,从我国数据中心发展角度,以及国际化竞争力方面来看,有了百度云计算(阳泉)中心作为样板和成功案例,我国绿色智能数据中心的涌现也将会很快到来。